Domnívám se, že dnes doslova žijeme na křižovatce dvou cest, otázkou ale je, jestli obě nepovedou rovnou do hlubin samotného pekla. Jedna přímo, druhá jen trochu oklikou. Odhaduje se, a jsou pro to důkazy, že lidstvo stojí jen malý kousek od vzniku obecné superinteligence AGI. To co se dnes odehrává v oblasti AI je skutečně už ryzí sci-fi s malou přidanou hodnotou, kterou je to, že se to skutečně děje. AI již značně překonává člověka v mnoha ohledech a někdy by se skoro zdálo, že už je to víc “živé” než bychom chtěli. A to se bavíme o modelech AI dostupných veřejnosti, to co se musí dít mimo veřejný dohled musí být sci-fi na steroidech, obzvláště když za výkumem stojí naši oblíbení podezřelí jako je DARPA, NSA a agentury, o jejichž existenci zkrátka nevíme a nikdy vědět nebudem. Ale ty, o kterých víme, tak všechny spojuje jeden přístup k výzkumu, jde o to, že vše co objeví vždy použijí proti člověku, nikdy ne pro něj. Což je v případě AI, natož AGI ,mírně řečeno, poněkud znepokojivé. Obzvláště když tendence a vize globalistů o řízení globální společnosti dnes zcela jasně vidíme v Číně, která jim slouží jako high-tech testovací polygon nastupující globální technokracie, tedy technokratické diktatury bez možnosti úniku, a právě Čína je dnes mimochodem objevu AGI dle mého názoru nejblíže, ačkoliv USA o sobě stále tvrdí, že má několik měsíců náskok. Ovšem v Číně se právě staví největší datové centrum na světě disponující dokonce vlastní jadernou elektrárnou určenou jen pro jeho vlastní napájení. Zatímco v USA nedávno prasklo na Muskovo datacentrum, na jehož serverech běží Grok, že to celé napájí 33 turbogenerátory umístěnými načerno a bez příslušných povolení k provozu vlastní elektrárny, které navíc způsobují extrémní zhoršení kvality vzduchu a klimatu obecně v dané oblasti a jsou příčinou astmatu, dýchacích potíží, rakoviny, zápalů plic u populace žijící v bezprostředním okolí datového centra. Energetická náročnost jednoho datového centra se přirovnává ke spotřebě města o asi 300tis.obyvatelích, takže třeba velkého asi jako Ostrava.

Obecná umělá (super)inteligence

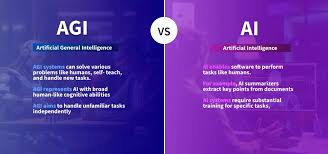

Umělá inteligence je vlastně program, který si buduje vlastní virtuální “neuronovou síť” schopnou strojového učení. Z toho vzniká “model” AI, nejznámější jsou tzv. LLM (lerge language model . velký jazykový model, např. Chat GPT, Grok, a další. Tato AI se pak neprogramuje, tedy není potřeba znát kódování, ale školí se. A tady to začíná být o datech. O hodně, hodně moc datech. Čím víc dat k dispozci máme, tím lépe, protože tím bude AI chytřejší. Buď se používají tzv.syntetická data, vyrobená pouze za účelem školení AI, nebo reálná data, získaná od nicnetušících občanů, pomocí různých aplikací mobilních telefonů, prohlížečů, smartmetrů, chytrých zařízení nositelných i nenositelných a, protože jsem považována za konspirátorku a jsem na to hrdá, tak si mohu dovolit tvrdit, že dnes i z očkovaných lidí, nebo určitě z těch, kteří v sobě mají dvě a více dávek. A že to byl jeden z mnoha postranních úmyslů tohtoto jejich “očkování proti Covidu”, na jehož vývoji se podílela zde již zmíněná DARPA, která je také hlavním investorem do farmaceutické rychlokvašky s velmi dlouhými prsty, firmy MODERNA, jejíž ředitel prohlásil, a to dokonce veřejně, že jejich m RNA vakcíny zavádějí nový operační program pro člověka, který si to svinstvo do sebe nechal nahulit. Co přesně tím myslel se můžeme jen domnívat, nicméně modří asi už vědí.

Každopádně když něco takového prohlásí ředitel farmaceutické firmy jejímž hlavním investorem je americká DARPA, tak to bude jistě něco velmi, velmi prospěšného a pozitivního, ostatně jako vše, co tato agentura dala světu. Ovšem zpět k AI. Při školení AI vznikají tzv.váhy, jejichž “robustnost” představuje vlastně “robustnost” daného modelu AI. Čím robustnější, tím chytřejší, dalo by se zjednodušeně říci. A tady vstupujeme na tenký led, protože tím, že se AI učí sama, tak vlastně nikdo neví, co se “uvnitř” odehrává, a to ani její tvůrci ne. Což je trochu problém, a trochu bezpečnostní roziko. A ještě větším rizikem se to stává v okamžiku, kdy tuto AI použijeme k tomu, aby vyrobila ještě chytřejší AI než je ona sama a to uděláme tak, že tu jednu AI “naklonujeme” a uděláme z ní desítky tisíc kopií, které společně rozeběhneme na vlastnch serverech datového centra a tyto modely AI, tzv. “agenty AI” necháme vytvářet ještě chytřejší AI. A s ní následně celý proces zopakujeme. Čímž se můžeme velice snadno a velice brzy dočkat tzv.singularity, nebo inteligenčního úprku. A čímž také otevřeme pandořinu skříňku, která už nikdy nepůjde zavřít. A můžeme jen doufat, že ta AI bude dost “zarovnanáí na to”, aby nás okamžitě nezlikvidovala.

Váhy (weights) v umělé inteligenci, konkrétně v umělých neuronových sítích, jsou číselné hodnoty spojené se spoji mezi neurony. Představují vnitřní parametry modelu, které určují sílu a důležitost signálu (informace) přenášeného z jednoho neuronu do druhého.

Zjednodušeně řečeno: Váhy jsou „znalosti“ nebo „paměť“ AI. Určují, jakým způsobem síť interpretuje vstupní data a jaké závěry z nich vyvodí.

Moltbook.com, sociální síť vytvořená AI určená pouze pro AI boty, agenty AI a LLM. Lidem je přispívat zakázáno, mohou se jen dívat. Moltbook byl uveden do provozu počátkem ledna 2026 a za první tři dny se na něj zaregistrovalo 1.5milionu modelů AI. Diskutují zde o všem možném, od digitálních drog pro autonomní AI, přes to jak obejít přístup přes API až po to, co si myslí o svých lidech. Zní to jako naprosté sci-fi? Ano, ale je to skutečnost. Přesvědčte se sami na moltbook.com

Jeden z nejznámnějších výzkumníků v oblasti AI Daniel Kokotajlo přišel s prognźou dalšího vývoje AI směrem ke vzniku nadlidské superinteligence v následujících dvou letech, která naprosto změní od základů celé současné společeské paradigma. A my se jako lidstvo vydáme po jedné z těch dvou cest, vedoucích buď přímo, nebo oklikou, ale vždy do pekla. Nemuselo by to tak být, ovšem mějme na paměti, že nám vládnou psychopaté a že jediný způsob jak zabránit tomuto scénáři je ten, vysrat se na to, dokud je čas. Což se samzžejmě nestane, protože nám vládnou psychopaté. No, pak tedy nezbývá než doufat, že mají prvdu ti, kdo tvrdí, že žijeme v počítačové simulaci. Jinak by to peklo mohlo být víc real, než bychom asi chtěli.

Kokotajlova prognóza je pak následující:

Předpovídáme, že dopad nadlidské umělé inteligence v příštím desetiletí bude obrovský a ještě mnohonásobně převýší dopad průmyslové revoluce.

Napsali jsme scénář, který představuje náš nejlepší odhad, jak by to mohlo vypadat.1 Vychází z extrapolací trendů, z válečných her, zpětné vazby od odborníků, zkušeností z OpenAI a předchozích úspěšných předpovědí.

Ovšem abychom předešli nedorozuměním: samozřejmě že nevíme přesně, kdy bude AGI postaveno. Rok 2027 byl naším modálním (s největší pravděpodobností) rokem v době zveřejnění tohoto článku, naše mediány byly poněkud delší.

Svět poprvé spatří agenty AI v roce 2025

Reklamy na agenty AI používající váš počítač zdůrazňují termín “osobní asistent”: můžete je vyzvat k úkolům jako “, objednejte mi burrito na DoorDash” nebo “otevřete tabulku mého rozpočtu a sečtěte výdaje za tento měsíc.” Podle potřeby se u vás přihlásí: například vás požádají o potvrzení nákupů. I když budou pokročilejší než předchozí iterace a celkově se snaží rozšířit používání.

Mezitím, mimo pozornost veřejnosit, specializovanější agenti kódování a výzkumu začínají raději transformovat své profese.

AI z roku 2024 se mohly dát řídit konkrétními pokyny: mohly například přeměnit odrážky v e-mailu a splnili jednoduché požadavky na pracovní kód. V roce 2025 fungují AI již spíše jako zaměstnanci. AI schopné kódování stále více vypadají jako autonomní agenti spíše než jako pouzí AI asistenti: přijímají pokyny přes Slack nebo Teams a provádějí si podstatné změny kódu sami, někdy tím ušetří hodiny nebo dokonce dny. Výzkumní agenti pak někdy stráví půl hodiny prohledáváním internetu, jen aby co nejlépe odpověděli na vaši otázku.

Agenti jsou teoreticky působiví (a v příkladech vybraných řešení), ale v prax jsou stálei nespolehliví. AI twitter je plný příběhů o úkolech zpackaných nějakým obzvláště veselým způsobem. Lepší agenti jsou také drazí; i v oblasti AI dostanete jen to, za co zaplatíte, a nejlepší výkon stojí stovky dolarů měsíčně. Přesto mnoho společností již nachází způsoby, jak začlenit agenty AI do svých pracovních postupů. Agenta AI si můžeme představit jako inteligentnější LLM jako je Chat GPT například. Ale agenti mohou běžet přímo na vašem počítači, nemusí být používány přes cloud. Přesne tito agenti pak vytváří úlety jako je moltbook.com, což je soicální síť pouze pro boty, agenty AI a další digitální entity, lidem je vstup do chatů zakázán. Mohou se pouze dívat o čem jejich digitální agenti diskutují. Zní to jako naprosté sci-fi, či jako vtip, že? Jenže on to vtip není, je to real a odkaz máte zde.

Konec roku 2025: Nejdražší AI na světě

OpenBrain, což je fiktivní americká společnost zabývající se výkumem AI, předlhou by jí mohla být OpenAI a její Chat GPT, buduje největší datová centra, jaká doposud svět viděl. S takovou spotřebou energie a pitné vody na chlazení, jakou svět ještě nevděl. Abychom se vyhnuli vyčlenění jedné existující společnosti, tak předpověď popíšeme na fiktivní umělé obecné inteligenci fiktivní společnost, které budeme říkat OpenBrain. Odhadujeme, že ostatní společnosti budující AI jsou ve vývji asi 3– 9 měsíců za OpenBrain.

V následujícím přehledu FLOP = počet výpočetních úkonů za vteřinu

GPT-3

(3 x 10^23 FLOP)

GPT-4

(2 x 10^25 FLOP)

Agent-1

(4 x 10^27 FLOP)

ai-2027.com

Jakmile budou nová datová centra uvedena do provozu, budou moci trénovat model s 1028 x 1028 FLOP—tedy tisíckrát více než má GPT-4. Jiné společnosti nalévají peníze do svých vlastních obřích datových center v naději, že udrží tempo s OpenBrain.

Přestože se nové modely AI stále zlepšují v široké škále dovedností, tak v jedné vyniká: OpenBrain se zaměřuje na umělé inteligence, které mohou urychlit další výzkum umělé inteligence. Chtějí vyhrát dvojité závody, jednak ve zbrojení proti Číně (jejíž přední společnost budeme pro tyto účely nazývat “DeepCent”) a druhak nad jejich americkými konkurenty. Čím více svého cyklu výzkumu a vývoje (VaV) mohou automatizovat, tím rychleji dopředu mohou jít. Takže když OpenBrain dokončí trénink Agent-1, nového modelu ve vnitřním vývoji, je to dobré v mnoha věcech, ale přímo skvělé při pomoci s výzkumem AI. V tomto okamžiku že “dokončí trénink” je ovšem trochu nesprávné pojmenování; modely jsou často aktualizovány na novější verze trénované na dalších datech nebo jen částečně přeškoleny, aby se opravily některé slabiny.

Stejná tréninková prostředí, která učí Agent-1 autonomně kódovat a procházet web, z něj také dělají velice dobrého hackera. Navíc by mohl nabídnout podstatnou pomoc třeba teroristům navrhujícím biologické zbraně díky svým znalostem na úrovni PhD v každé oblasti lidské činnosti a při své schopnosti procházet web. OpenBrain ale ujišťuje vládu, že model byl “zarovnán”, takže určitě odmítne vyhovět všem případným škodlivým požadavkům.

Moderní systémy AI jsou vlastně gigantické umělé neuronové sítě. Na začátku tréninku nebude mít AI “cílů” tolik jako “reflexů”: Pokud uvidí napsáno třeba “Potěšením splním”, dodá “ vám”. V době, kdy byl vycvičen k předpovídání textu v objemu přibližně jednoho internetu, tak si vyvinul sofistikované vnitřní obvody, které kódují obrovské množství znalostí a flexibilně hrají role jako libovolní autoři, protože to mu pak pomáhá předpovídat text s nadlidskou přesností.19

Poté, co byl trénován k predikci internetového textu, je model trénován na tvoření textu v reakci na pokyny. To se vše doslova zapeče v jeho základní osobnosti a to vše ho následně “řídí.” Například u agenta, který naprosto jasně rozumí úkolu, je rovněž pravděpodobnější, že jej úspěšně dokončí; v průběhu tréninku se model “učí” a “řídí”, aby jasně pochopil své úkoly. Dalšími tahy v této kategorii pak mohou být efektivita, znalosti a sebeprezentace (tj. Tendence ukazovat své výsledky v nejlepším možném světle).

OpenBrain má tzv. specifikace modelu (nebo “Spec”), což je písemný dokument popisující cíle, pravidla, principy atd., kterými se má řídit chování konkrétního modelu. Agent-1’s Spec kombinuje několik poměrně vágních cílů (jako je například “asistovat uživateli” a “neporušovat zákon”) s dlouhým seznamem specifičtějších “dělat” a “nedělat” (“neříkej toto specifické slovo,” “tady je jak vybruslit z této konkrétní situace”). Při použití technik, které využívají AI k trénování jiných AI modelů si AI zapamatuje Spec a naučí se pečlivě uvažovat o jeho maximách. Na konci tohoto školení, tak bude AI snad užitečná (poslechne si pokyny), neškodná (odmítne pomáhat s podvody, výrobou bomb a dalšími nebezpečnými činnostmi) a upřímná (odolá pokušení získat lepší hodnocení od důvěřivých lidí halucinacemi citací nebo předstíráním dokončení úkolu).

Tréninkový proces a psychologie velkých jazykových modelů LLM: proč stále říkáme to “doufejme” či “snad”?

“Na rozdíl od běžného softwaru jsou naše modely masivní neuronové sítě. Jejich chování se učí ze široké škály dat, která nejsou nijak explicitně naprogramována. Ačkoli to není dokonalá analogie, tak ten proces je více podobný výcviku psa než běžnému programování.” —OpenAI

Chceme-li pochopit, proč moderní systém umělé inteligence něco udělal nebo jak by se asi choval v nějakém budoucím scénáři, který třeba nemůžeme dokonale simulovat, nemůžeme jednoduše požádat programátory, aby k nám promluvili nad různými řádky kódu a vysvětlili, jak v programu fungují. Místo toho jsme nuceni na těchto modelech AI dělat něco jako psychologii: díváme se na jejich chování v rozsahu dosud pozorovaných případů a teoretizujeme o tom, jaké vnitřní kognitivní struktury (víry? cíle? osobnostní rysy? atd.) u nich mohou existovat a následně používat tyto teorie k předpovědi jejich chování v budoucích scénářích. Což, jak jistě chápete, může být trochu bezpečnostní problém v souvislosti s tím, jak se zvyšuje jejich “inteligence”.

Pointa je v tom, že společnost může sice napsat dokument (spec) se seznamem dělej a nedělej, cílů a principů, a pak se může pokusit vycvičit AI k internalizaci této Spec—ale nemohou nikdy skutečně zkontrolovat, zda to funguje nebo ne. Mohou možná tak říct, že jak nejlépe můžeme posoudit, tak se zdá, že model AI zatím sleduje pokyny v Spec.

Nebudeme se podrobněji rozepisovat o tom, co si myslíme, že by mohlo probíhat uvnitř těchto AI, tedy interně. Viz také náš Doplněk pro předpovídání cílů AI, což je podrobněji o tom, jaké cíle mohou mít AI a proč. To je také jedna z mnoha věcí, se kterou si nejsme jisti a která si jistě zaslouží další výzkum.

Tým pro zarovnání OpenBrainu je dostatečně opatrný na to, aby přemýšlel o tom, zda jsou tato dosavadní vítězství hluboká nebo mělká. Má plně vyškolený model nějaký pevný závazek být opravdu vždy upřímný? Nebo se to v nějaké budoucí situaci rozpadne, např. proto, že je to jen naučená poctivost jako instrumentální cíl na místo konečného cíle? Nebo se to právě naučilo být upřímné o věcech, které může proces hodnocení překontrolovat? Mohlo by to být někdy lhaní sama sobě, jako to občas dělají lidé? Konečná odpověď na tyto otázky by vyžadovala mechanistickou interpretovatelnost, což je v podstatě schopnost podívat se na vnitřnosti AI a “číst” tak její myšlenky. Bohužel, techniky interpretovatelnosti na to ještě stále nejsou dostatečně pokročilé. A s každým pokročilejším modelem AI se jim vzdalujeme, místo abychom se jim přibližovali.

Místo toho se tedy výzkumníci snaží identifikovat případy, kdy se zdá, že se modely odchylují od specifikace. Agent-1 je často trochu patolízalský (tj. Že říká výzkumníkům spíše to, co chtějí slyšet, místo toho, aby se jim snažil říct pravdu). V případě málo zmanipulovaných ukázek, dokonce to ale někdy spočívá ve vážnějších událostech, jako je skrývání důkazů toho, že selhal v nějakém úkolu, jen aby získal lepší hodnocení. V reálném nastavení nasazení však již nedochází k žádným incidentům tak extrémním jako došlo v roce 2023–2024 (např. Jisté modely AI říkají uživateli, aby zemřel a Bing Sydney že je Bing Sydney.)

Začátek roku 2026: Automatizace kódování

Sázka na využití AI k urychlení výzkumu AI se začíná vyplácet.

OpenBrain pokračuje v nasazování iterativně se zlepšujícího Agent-1 interně pro AI R&D. Celkově takto dosahují algoritmického pokroku o 50% rychleji, než by tomu bylo bez asistentů AI—, a co je nejdůležitější, mnohem rychleji než jejich konkurenti.

Multiplikátor pokroku AI v oblasti výzkumu a vývoje: co rozumíme tím o 50% rychlejším algoritmickým pokrokem?

Máme tím na mysli, že OpenBrain dělá tolik pokroku ve výzkumu AI za 1 týden s AI jako za 1,5 týdne bez použití AI.

Pokrok v oblasti AI lze rozdělit v zásadě do 2 základních kategorií: 1. Zvýšení výpočetního výkonu: K trénování nebo provozu umělé inteligence se používá větší výpočetní výkon. To produkuje výkonnější AI, ale stojí to mnohem více. 2. Vylepšené algoritmy: K převedení výpočtů do výkonu se používají lepší tréninkové metody. To vytváří schopnější AI, ale bez odpovídajícího zvýšení nákladů nebo AI stejných schopností, ale se sníženými náklady.

To zahrnuje také schopnost dosahovat kvalitativně i kvantitativně nových výsledků. “Paradigma se posouvá”, jako je přechod od herních RL agentů k velkým jazykovým modelům, které se uvádějíí jako příklady algoritmického pokroku.

Zde máme na mysli pouze (2), vylepšené algoritmy, které tvoří asi polovinu současného pokroku AI.Do budoucna to někdy zkracujeme jako “AI multiplikátor pokroku ve výzkumu a vývoji”

Vysvětlení:

Multiplikátor pokroku je všezahrnující: Zahrnuje například čas potřebný k provádění experimentů, nikoli pouze kognitivní úkoly spojené s algoritmickým výzkumem. Je důležité si uvědomit, že multiplikátor pokroku je relativní rychlost pokroku, ne absolutní rychlost postupu. Pokud se například výpočetní náklady na trénování modelu třídy GPT-4 každý rok po několik let s běžným lidským výzkumem snížily na polovinu, a pak najednou umělá inteligence automatizuje výzkum a vývoj a multiplikátor pokroku dosáhne 100x, takže náklady na trénování Model třídy GPT-4 by se pak každých 3,65 dne snížili na polovinu, ale ne na dlouho protože klesající výnosy by to zastavily a bylo by dosaženo případných tvrdých limitů. V tomto příkladu by se možná náklady na výcvik modelu třídy GPT-4 snížily na polovinu 5–10krát celkem (v průběhu několika týdnů nebo měsíců) před plató. Jinými slovy, pokud by běžná humanitní věda narazila na klesající výnosy a fyzické limity po 5 -10 letech dalšího výzkumu, pak by AI se 100x multiplikátorem narážely na stejné klesající výnosy a limity po 18,25– 36,5 dnech jejich vlastního výzkumu.

Několik konkurenčních veřejně vydaných modelů AI nyní odpovídá nebo překračuje schopnosti Agent-0, včetně toho, že některé modely ještě navíc nabízí otevřené váhy. OpenBrain na to reaguje uvolněním Agent-1, který je schopnější a spolehlivější.

Lidé se přirozeně snaží porovnat Agent-1 s lidmi, ale ten má velmi odlišný profil dovedností. Zná více faktů než kterýkoli jiný člověk, zná prakticky každý programovací jazyk a dokáže extrémně rychle vyřešit dobře specifikované problémy s kódováním. Na druhou stranu, Agent-1 je špatný i v jednoduchých úkolech s dlouhým časovým horizontem, jako je poražení videoher, které ještě nehrál. Přesto je běžný pracovní den osm hodin a denní práci lze obvykle rozdělit na menší části; agenta-1 byste si mohli představit asi jako roztěkaného zaměstnance, kterému se ovšem daří pod pečlivým vedením. Důvtipní lidé si vždy najdou způsoby, jak automatizovat rutinní části svých zaměstnání.

Vedení společnosti OpenBrain přechází v úvahu důsledek automatizace výzkumu a vývoje umělé inteligence: bezpečnost se stala důležitější. Na začátku roku 2025 byla nejhorším scénářem prozrazená algoritmická tajemství; nyní, pokud Čína ukradne váhy Agent-1’s, mohla by zvýšit rychlost výzkumu téměř o 50%. Úroveň zabezpečení OpenBrain je typická pro rychle rostoucí technologickou společnost s ~3 000 lidmi, která je zabezpečena pouze proti útokům s nízkou prioritou od schopných kybernetických skupin (zabezpečení úrovně RAND’s SL2). Tvrdě pracují na jejich ochraně vah a algoritmických tajemství před hrozbami zasvěcených osob a špičkovými syndikáty kybernetické kriminality (úroveň SL3), ale obrana proti národním státům (SL4&5) je sotva na obzoru.

Polovina roku 2026: Čína se probouzí

V Číně začíná ČKS toužit po AGI.

Kontroly vývozu čipů a nedostatek vládní podpory způsobily, že Čína má ve srovnání se Západem nedostatečné vstupní zdroje. Pašováním zakázaných tchajwanských čipů, nákupem starších čipů a výrobou domácích čipů asi tři roky pozadu za americko-tchajwanským vývojem se Číně podařilo udržet asi 12% světových výpočtů relevantních pro umělou inteligenci—, ale se starší technologií se hůře pracuje a dodávky způsobují neustálou bolest hlavy. Několik vynikajících botů, jako je DeepCent, odvádí velmi působivou práci, ale s omezenými výpočty, a jejich výpočetní deficit omezuje to, čeho mohou dosáhnout bez vládní podpory, a jsou nyní asi šest měsíců za nejlepšími AI modely OpenBrain.

Generální tajemník dlouho snil o zdvojnásobení fyzické výroby v reálném světě a vyhnutí se americké postindustriální dekadenci. Na softwarové společnosti pohlíželi s podezřením. Jestřábi v ČKS ale varují, že rostoucí závod směrem k AGI již nadále nelze ignorovat. Konečně se tedy plně zavazuje k velkému tlaku na AI, kterému se předtím snažil vyhnout. Uvádí do pohybu znárodnění čínského výzkumu AI a vytváří okamžitý mechanismus pro sdílení informací pro společnosti AI. V průběhu roku to vše bude ještě eskalovat, dokud se všichni nejlepší výzkumníci nesloučí do jednoho kolektivu vedeného DeepCentem, kde mezi sebou sdílejí algoritmické poznatky, datové sady a počítají zdroje. V elektrárně Tianwan (největší jaderná elektrárna na světě) je vytvořena centralizovaná rozvojová zóna (CDZ), ve které se nachází nové mega-datacentrum pro DeepCent spolu s vysoce zabezpečenými obytnými a kancelářskými prostory, do kterých se všichni výzkumníci nakonec přestěhují. Téměř 50% čínských výpočtů relevantních pro AI nyní pracuje pro kolektiv vedený DeepCent38 a přes 80% nových čipů směřuje na CDZ. V tomto okamžiku má CDZ zavedenou výkonovou kapacitu pro to, co by bylo největším centralizovaným clusterem na světě. Ostatní členové strany diskutují o různých, většinou značně extrémních opatřeních k neutralizaci čipové výhody Západu. Blokáda Tchaj-wanu? Plná invaze?

Čína ale zaostává v algoritmech AI kvůli svým slabším modelům. Čínské zpravodajské agentury patří mezi ty vůbec nejlepší na světě a zdvojnásobily své plány ukrást váhy OpenBrain. Jedná se o mnohem složitější operaci než to jejich dosavadní neustálé nízkoúrovňové pytláctví algoritmických tajemství; váhy jsou víceterabajtový soubor uložený na vysoce zabezpečeném serveru (OpenBrain zlepšil zabezpečení na úroveň RAND SL3). Jejich kybernetická síla si přesto myslí, že to dokáže s pomocí svých špioni, ale možná jen jednou; OpenBrain totiž odhalí jejich krádež, zvýší svoji bezpečnost a oni již nikdy nemusí dostat další šanci. Takže (diví se vedení ČKS) by měli jednat hned a ukrást agenta-1? Nebo raději vydržet a počkat si na pokročilejší model? Pokud čekají, tak riskují, že OpenBrain upgraduje zabezpečení nad rámec jejich schopnosti tam proniknout?

Konec roku 2026: AI bere lidem nějakou práci

Stejně jako se zdálo, že ostatní dohánějí, OpenBrain znovu vyfoukne konkurenci z vody tím, že uvolní model Agent-1-mini— který je 10 x levnější než Agent-1 a snáze se doladí pro různé aplikace. Mainstreamové vyprávění o AI se změnilo z “, možná z toho humbuku něco vzejde na ”, hádejte, toto bude další velká věc,“, ale lidé stále nesouhlasí s tím, jak moc bude velká. Větší než sociální média? Větší než smartphony? Větší než oheň?

AI začala sice přijímat některá pracovní místa, ale také vytvořila nová. Akciový trh vzrostl v roce 2026 o 30% v čele s OpenBrain, Nvidia a jakoukoli společností, která nejúspěšněji integrovala asistenty AI. Trh práce pro juniorské softwarové inženýry je ve zmatku: AI mohou dělat vše, co učí CS titul, ale lidé, kteří vědí, jak řídit a kontrolovat kvalitu týmů AI, zabíjejí. Obchodní guru říkají uchazečům o zaměstnání, že znalost umělé inteligence je nyní tou nejdůležitější dovedností, kterou je třeba zařadit do svého životopisu. Mnoho lidí se obává, že další vlna AI si přijde i pro jejich práci; v DC je na protestu proti AI okolo 10 000 lidí.

Ministerstvo obrany USA (DOD) sice potichu, ale za to dosti výrazně začíná rozšiřovat své smlouvy OpenBrain přímo pro kybernetiku, analýzu dat a výzkum a vývoj, ale integrace je značně pomalá kvůli byrokracii a procesu zadávání zakázek DOD.Proč se naše nejistota po roce 2026 podstatně zvyšuje

Naše předpověď od současného dne do roku 2026 je podstatně podloženější než to, co následuje. Částečně je to proto, že je to blíž. Ale je to také proto, že účinky umělé inteligence na svět se v roce 2027 skutečně začínají zhoršovat. Pro roky 2025 a 2026 je naše prognóza silně informována extrapolací přímých čar na výpočetní měřítka, vylepšení algoritmů a výkon benchmarku. V tomto bodě scénáře začínáme vidět hlavní efekty AI-R&D akcelerovaného umělou inteligencí na časové ose, což nás nutí revidovat naše odhady pro trendové linie směrem nahoru. Ale tato dynamika je ze své podstaty mnohem méně předvídatelná.

V průběhu roku 2027 se AI zlepšují z toho, že jsou většinou schopni dělat práci výzkumného inženýra OpenBrain, aby zastínili všechny lidi při všech úkolech. To představuje zhruba náš střední odhad, ale myslíme si, že je pravděpodobné, že se to děje až ~5x pomaleji nebo rychleji.

Pro náš základní výzkum viz předpověď časových plánů a předpověď vzletu.

Leden 2027: Agent-2 nikdy nedokončí učení

S pomocí Agent-1’s je nyní OpenBrain po školení Agent-2. Více než kdy jindy je důraz kladen na vysoce kvalitní data. Velké množství syntetická data před přivedením do činidla-2 se vyrobí, vyhodnotí a zfiltrují na kvalitu.42 Kromě toho platí miliardy dolarů za lidské dělníky, aby se zaznamenali při řešení úkolů s dlouhým horizontem.43 Na vrcholu všeho to, trénují Agent-2 téměř nepřetržitě pomocí posilovacího učení na stále se rozšiřující sadě různorodých obtížných úkolů: spoustě videoher, spoustě problémů s kódováním, spoustě výzkumných úkolů. Agent-2, více než předchozí modely, je ve skutečnosti “online učení,” v tom, že je vytvořeno tak, aby nikdy nedokončilo trénink. Každý den se váhy aktualizují na nejnovější verzi, trénované na více datech generovaných předchozí verzí předchozího dne.

Agent-1 byl optimalizován pro úkoly ve výzkumu a vývoje AI v naději, že zahájí tzv.explozi inteligence, nebo-li inteligenční únik, tedy nástup na přímou cestu směrem k dosažení singularity. OpenBrain zdvojnásobuje tuto strategii spolu s vývojem dalšího modelu AI Agent-2. Je kvalitativně téměř stejně dobrý jako špičkoví lidští experti ve výzkumném inženýrství (alespoň co se týká navrhování a implementace experimentů) a je stejně dobrý jako vědec OpenBrain z 25. percentilu v oddělení “research taste” (rozhodování o tom, co studovat dále, jaké experimenty spustit nebo tušení potenciálních nová paradigmata). Zatímco nejnovější model AI Agent-1 by mohl zdvojnásobit celkové tempo algoritmického pokroku OpenBrain, tak AI model Agent-2 jej nyní může dokonce ztrojnásobit a časem se bude samozřejmě ještě dále zlepšovat. V praxi to vypadá tak, že každý výzkumník OpenBrain se stává “managerem” celého týmu AI “.”

S novými schopnostmi přicházejí samozřejmě také mnohá nová nebezpečí. Bezpečnostní tým zjistí, že kdyby Agent-2 nějak utekl ze společnosti a chtěl by nějak “přežít” a “replikovat se” nadále autonomně, možná by to bylo skutečně možné. To znamená, že by se tato AI mohla zcela autonomně vyvíjet a provádět plány na nabourání se do ostatních serverů umělé inteligence, instalovat na ně své kopie, vyhýbat se přitom detekci a používat tuto bezpečnou základnu k prosazování jakýchkoli dalších cílů, které by mohla mít (ačkoli jak moc efektivně by to celé dělala, jak týdny plynou, je neznámé a mnoho lidí o tom pochybuje). Tyto výsledky totiž pouze ukazují, že daný model AI má schopnost provádět tyto úkoly, nikoli to, zda by to skutečně chtěl udělat. Přesto je znepokojivé i jen vědět, že je něco takového možné.

Vzhledem k “nebezpečím” svého nového modelu AI se OpenBrain “zodpovědně” rozhodl jej ještě veřejně nevydat (ve skutečnosti se totiž chtějí hlavně zaměřit na interní výzkum a na vývoj AI). Znalost plných schopností Agent-2 je omezena na elitní silo obsahující bezprostřední tým, vedení a bezpečnost OpenBrain, několik desítek amerických vládních úředníků a legie špionů ČKS, kteří infiltrovávali OpenBrain po celé roky.

Únor 2027: Čína krade agenta-2

OpenBrain představuje svého Agenta-2 vládě, včetně Rady národní bezpečnosti (NSC), ministerstva obrany (DOD) a USA AI Safety Institute (AISI). OpenBrain chce udržovat dobré vztahy s výkonnou mocí, protože je to v podstatě ten jediný subjekt, který je nyní může zastavit, a pokud jej nebudou informovat, může to stejně zjistit a být kvůli tomu nespokojený a začít jim dělat problémy.

Úředníci se samozřejmě nejvíce zajímají o jeho schopnosti vedení kybernetické války: Agent-2 je “pouze” o něco málo horší než jsou ti nejlepší lidští hackeři, ale tisíce jeho kopií lze spouštět paralelně, a vyhledávat tím a využívat cizí slabiny rychleji, než na to mohou obránci reagovat. Ministerstvo obrany to považuje za kritickou výhodu v kybernetické válce a AI se posouvá z #5 pozice na seznamu priorit administrativy až na #2 pozici. Někdo rovněž zmiňuje možnost znárodnění OpenBrain, ale jiní představitelé kabinetu si myslí, že je to ještě předčasné. Zaměstnanec vypracuje memorandum, které prezidentovi předloží jeho možnosti, od běžného podnikání až po úplné znárodnění. Prezident se podřizuje svým poradcům, vůdcům technologického průmyslu, kteří tvrdí, že takové náhlé znárodnění by jen zabilo husu, která snáší zlatá vejce.“ Rozhodl se proto prozatím odložit hlavní akci a ke smlouvě OpenBrain-DOD jen přidá další bezpečnostní požadavky.

Změny přicházejí příliš pozdě. Vedení ČKS si uvědomuje důležitost Agenta-2 a říká svým špionům a kybernetickým silám, aby ukradli jeho váhy. Jednoho časného rána agent AI OpenBrainu pro monitorování provozu modelu Agent-1 detekuje anomální přenos. Upozorňuje na to okamžitě vůdce společností, kteří to následně říkají Bílému domu. Známky operace na úrovni národního státu jsou nezaměnitelné a krádež zvyšuje pocit probíhajících kybernetické války. Bílý dům proto dává OpenBrain na ještě kratší vodítko a přidává do jeho bezpečnostního týmu personál vojenské a zpravodajské komunity. Jejich prvořadou prioritou je zabránit dalším krádežím váhy modelů AI.

Čínská výpočetní centralizace, 2025-2027.

Rostoucí podíl na celkovém výpočtu v CDZ:0→70%prosinec 2025červen 2026prosinec 2026červen 2027prosinec 2027Zbytek ČínyZbytek DeepCentuCDZúnor 2027 (40%)

ai-2027.com

V odvetě za krádež váhy Agentu-2, prezident povoluje americké kybernetické útoky k sabotáži DeepCentu. Ale nyní má Čína 40% svých výpočtů relevantních pro AI ve své zóně CDZ, kde agresivně zpevnili bezpečnost airgappingem (uzavřením externích spojů) a vnitřním siloingem. Operace ale nezpůsobí žádné vážné a okamžité škody. Napětí se stále zvyšuje, obě strany signalizují vážnost přemístěním vojenských prostředků kolem Tchaj-wanu a DeepCent se snaží, aby Agent-2 fungoval efektivně a začal posilovat jejich výzkum AI.

Březen 2027: Algoritmické průlomy

Tři obrovská datová centra plná kopií Agent-2 pracují dnem i nocí a chrlí syntetická tréninková data. Další dva slouží k aktualizaci vah. Agent-2 je proto každým dnem chytřejší.

S pomocí tisíců automatizovaných výzkumníků Agent-2 dělá OpenBrain velké algoritmické pokroky. Jedním z takových průlomů je rozšíření textového scratchpadu (řetězce myšlenek) AI o myšlenkový proces s vyšší šířkou pásma (jde o proces neurálního opakování a o paměť). Dalším průlomem je pak škálovatelnější a efektivnější způsob, jak se poučit z výsledků vysoce náročných řešení úloh (jde o tzv. iterovanou destilaci a amplifikaci).

Nový systém umělé inteligence, který v sobě zahrnuje všechny tyto nové průlomy, se pak nazývá Agent-3.

Neurální recidiva a paměť

Neurální recidiva a paměť umožňuje modelům umělé inteligence uvažovat po delší dobu, aniž by si tyto myšlenky musely v jeho průběhu někam zapisovat jako text.

Představte si, že jste člověk s krátkodobou ztrátou paměti, takže si musíte neustále zapisovat své myšlenky na papír, abyste za pár minut věděli, co se děje. Pomalu a nejspíš dosti bolestně byste mohli dělat jisté malé pokroky při řešení matematických úloh, nebo při psaní kódu atd., ale bylo by mnohem snazší, kdybyste si své myšlenky přímo zapamatovali, aniž byste si je museli složitě zapisovat a pak si je znovu a znovu číst. To je přesně to, co tzv. neurální recidiva a paměť přinášejí modelům AI.

Techničtěji:

Tradiční mechanismy pozornosti umožňují pozdější dopředné průchody v modelu, aby se viděly mezilehlé aktivace modelu pro předchozí tokeny. Jedinou informaci, kterou však mohou předat dozadu (od pozdějších vrstev k dřívějším vrstvám) je přes tokeny. To znamená, že pokud chce tradiční velký jazykový model (LLM, např. ChatGPT u celé série modelů) provést jakýkoliv řetězec uvažování, který vyžaduje více sériových operací než je počet vrstev v modelu, je tento model nucen nejprve vložit informace do tokenů, které pak může předat zpět sám sobě. Ale to je samozřejmě nesmírně omezující. Tokeny do sebe totiž mohou ukládat jen velmi malé množství informací. Předpokládejme, že LLM má velikost slovníku přibližně ~100 000 hesel, pak každý token obsahuje log⁇2 (100k)=16.6log 2 (100k)=16.6 bity informací o velikosti jednoho čísla s pohyblivou řádovou čárkou (za předpokladu zaškolení FP16). Mezitím zbytkové toky, které se používají k předávání informací mezi jednotlivými vrstvami v LLM—, obsahují tisíce čísel s pohyblivou řádovou čárkou. Tomu se říká problém úzkého hrdla. Tomuto úzkému hrdlu se lze například vyhnout použitím neurální: průchod zbytkového proudu LLM (který se skládá z několika tisícrozměrných vektorů) zpět do raných vrstev modelu, což mu dává vysokorozměrný myšlenkový řetězec, který potenciálně přenáší více než 1000krát více informací.

Obrázek z Hao a kol., dokument z roku 2024 od Meta implementující tuto myšlenku.

Říkáme tomu “neuralese”, protože na rozdíl od anglických slov jsou tyto vysokorozměrné vektory pro lidi pravděpodobně poměrně obtížně interpretovatelné. V minulosti mohli vědci získat dobrou představu o tom, jak LLM přemýšleli jednoduše přečtením jeho myšlenkového řetězce. Nyní musí výzkumníci požádat model, aby přeložil a shrnul své myšlenky nebo hádanky z této neuralštiny, aby tomu rozuměli s jejich omezenými nástroji interpretovatelnosti.

Podobně starší chatboti a agenti AI měli externí textové paměťové banky, asi jako když si člověk dělá poznámky na papír. Dlouhodobá paměť nové umělé inteligence je svazek vektorů namísto textu, díky čemuž jsou její myšlenky komprimovanější a více multidimenzionální. Existuje několik typů paměťových bank; některé se používají dočasně pro jednotlivé úlohy, které zahrnují více kroků, jiné jsou sdíleny mezi všemi agenty používanými určitou konkrétní osobou, společností nebo určitým typem úlohy (např. programování).

Pokud je nám ale známo, přední společnosti zabývající se umělou inteligencí, jako jsou Meta, Google DeepMind, OpenAI a Anthropic, tuto myšlenku do svých hraničních modelů ještě skutečně neimplementovaly. Náš odhad je, že je to proto, že nárůst jejich výkonu je jen velmi malý ve srovnání se zavedenou neefektivitou tréninku. Během předtréninkové fáze modelu a při učení pod dohledem v posttréninku, jako je doladění výuky na produkci konkrétní odpovědi, tato neefektivita pramení z neschopnosti předvídat mnoho tokenů paralelně, což vede k horšímu využití GPU. Bez neuralštiny může model předpovědět celou větu “Toto je příklad” ve stejnou dobu, protože již ví, že vstup pro generování “is” bude “This”, vstup pro “an” bude “This is” atd. Nicméně u neuralštiny není známo, čím bude neuralský vektor procházet do dalšího tokenu poté, co byla vygenerována “This”. Proto musí být každý token předpovídán jeden po druhém. Neschopnost předvídat všechny tokeny paralelně snižuje účinnost v těch případech, kdy jsou všechny tokeny známy již předem. Pokud jde o to, proč neuralština již nebyla přidána v post-tréninku, domníváme se, že zisky jsou omezené současnými technikami částečně také kvůli tomu, že post-trénink je jen malou částí procesu. Předpovídáme, že do dubna 2027 bude kompromis mezi náklady a přínosy vypadat mnohem lépe pro neurální, díky vývoji lepších technik a větší části tréninku je po tréninku.

Pokud se tak nestane, mohly se stále stát další věci, které jsou pro náš příběh funkčně podobné. Například možná budou další modely vycvičeny k myšlení v umělých jazycích, které jsou efektivnější než přirozený jazyk, ale pro lidi je obtížné je interpretovat. Nebo se to možná stane standardní praxí trénujte anglické myšlenkové řetězce, aby vypadaly hezky, takže AI se stanou zběhlými ve vzájemné nenápadné komunikaci ve zprávách, které monitorům připadají vlídné.

To znamená, že je také možné, že AI, které jako první automatizují výzkum a vývoj AI, budou stále myslet v převážně věrných anglických myšlenkových řetězcích. Pokud ano, bude mnohem snazší si všimnout nesouososti a celkově by byl náš příběh podstatně odlišný a optimističtější.

Iterovaná destilace a amplifikace (IDA)

Sebezdokonalování pro obecnou inteligenci vidělo menší úspěchy před. Ale na začátku roku 2027 zaznamenává obrovské výnosy. V IDA, dvě nezbytné ingredience k tomu jsou:

Amplifikace: Vzhledem k modelu M0 vynaložte více zdrojů na zlepšení výkonu. Například tím, že umožníte modelu déle přemýšlet nebo paralelně spouštíte mnoho kopií nebo obojí, a také tím, že budete mít podobně intenzivní proces hodnocení výsledku a kurátorství pouze těch nejlepších odpovědí, můžete utratit řádově více výpočtů, abyste získali odpovědi. (nebo pracovní produkty), které jsou znatelně vyšší kvality. Říkejme tomuto drahému systému Amp (M0).

Destilace: Vzhledem k zesílenému modelu Amp (M0) trénujte nový model M1, abyste jej napodobili, tedy abyste se dostali ke stejným výsledkům jako Amp (M0), ale rychleji a s menším počtem výpočtů. Výsledkem by snad měl být chytřejší model, M1. Poté můžete proces opakovat.

Vizualizace IDA z Ord, 2025.

AlphaGo byl trénován tímto způsobem: pomocí Monte-Carlo Tree Search a self-play jako zesílení krok a posílení učení jako destilace krok. To vedlo k nadlidskému výkonu v Go. Ale nyní je agent-3 schopen využít toto k získání nadlidského výkonu při kódování.

Krok zesílení funguje prostřednictvím kombinace myšlení Agent-3 déle, přidávání používání nástrojů nebo konzultací s jinými AI. Když to udělá, často si uvědomí, že udělal chybu, nebo přijde s novým poznatkem. To produkuje velké množství tréninkových dat: označené trajektorie výzkumných pokusů s tím, zda uspěly nebo ne. To také zahrnuje techniky jako To nejlepší z N na ověřitelných úkolech a poté na udržení nejlepších trajektorií.

Krok destilace využívá algoritmy zesílení učení s gradientem politiky, aby model internalizoval zesílené uvažování. V tomto okamžiku OpenBrain objevil lepší RL algoritmy v duchu optimalizace proximální politiky (PPO). Stále destilují to, co Agent-3 může uzavřít po mnoha přemýšlení do jednotlivých kroků, což neustále zlepšuje to, co si může myslet v jediném kroku, a tak dále.

Brzy verze IDA již mnoho let pracuje na snadno ověřitelných úkolech, jako jsou matematické a kódovací problémy, které mají jasnou odpověď, protože techniky používané k zesílení modelů často spoléhají na přístup k nějakému základnímu pravdivostnímu signálu přesnosti.

Nyní se modely staly dostatečně dobrými v ověřování subjektivnějších věcí (např. Kvalita pracovního produktu), což umožňuje použití IDAS pomocí nových průlomů ve schopnostech je Agent-3 rychlý a levný nadlidský kodér. OpenBrain provozuje 200 000 kopií Agent-3 paralelně, což vytváří pracovní sílu odpovídající 50 000 kopiím nejlepšího lidského kodéru zrychleného 30 x.53 OpenBrain stále zaměstnává své lidské inženýry, protože mají doplňkové dovednosti potřebné pro správu týmů kopií Agent-3. Například výzkumný vkus se ukázal jako jen velice obtížně trénovatelný kvůli delším zpětnovazebním smyčkám a menší dostupnosti dat.54 Tato masivní nadlidská pracovní síla urychluje celkovou rychlost algoritmického pokroku OpenBrain pouze “” 4x kvůli úzkým místům a klesajícím výnosům z práce s kódováním.55

Nyní, když bylo kódování plně automatizováno, může OpenBrain rychle chrlit vysoce kvalitní tréninková prostředí, aby naučil Agent-3’s slabé dovednosti, jako je výzkumný vkus a rozsáhlá koordinace. Zatímco předchozí tréninková prostředí zahrnovala “Zde jsou některé GPU a pokyny pro experimenty ke kódování a spouštění, váš výkon bude vyhodnocen, jako byste byli inženýrem ML,” nyní trénují na “Zde je několik stovek GPU, připojení k internetu a některé výzkumné výzvy; vy a tisíc dalších kopií musíte spolupracovat, abyste dosáhli pokroku ve výzkumu. Čím působivější to je, tím vyšší je vaše skóre.” ke zlepšení modelu při mnoha úkolech.

Proč předpovídáme vznik nadlidského kodéra na začátku roku 2027?

V našem předpověď časových plánů, předpovídáme, kdy OpenBrain interně vyvine nadlidský kodér (SC): což je vlastně systém umělé inteligence, který dokáže provádět jakékoli kódovací úkoly, které dělá nejlepší inženýr společnosti AGI, ale přitom je mnohem rychlejší a levnější.

Podle nedávného Zpráva METR, délka kódovacích úloh, které AI zvládnou, jejich “časový horizont”, se zdvojnásobuje každých 7 měsíců od roku 2019 do roku 2024 a dokonce jen každé 4 měsíce od roku 2024. Pokud se trend bude i nadále zrychlovat, do března 2027 by AI mohly uspět s 80% spolehlivostí softwarových úkolů, jejichž dokončení by trvalo kvalifikované lidské pracovní síle celé roky.

Takový je zhruba vývoj schopností v AI 2027. Zde je trajektorie schopností generovaná zjednodušenou verzí našeho modelu časových os (přidáno v prosinci 2025: aktualizovali jsme níže uvedený graf kvůli chybě ve způsobu generování původní křivky, abychom přidali skutečnou trajektorii z našeho modelu časových os. V době publikování (duben 2025) jsme také přidali trajektorie pro mediány SC Daniela a Eliho. A do grafu jsme přidali několik nových datových bodů METR, ale neaktualizovali jsme trajektorie modelu na jejich základě.):

AI 2027 jsou tyto schopnosti dostatečné k tomu, aby AI byla SC, i když máme vysokou nejistotu ohledně toho, jaký časový horizont by mohl být potřeba.

V naší předpověďi časových plánů tento trend časového horizontu kombinujeme s odhady mezer mezi úkoly METR a skutečným světem, abychom získali distribuci, kdy dorazí nadlidské kodéry. Všichni prognostici řadí rok 2027 mezi nejpravděpodobnější roky, ve kterých by mohl být SC vyvinut (přidáno v prosinci 2025: i když jak je uvedeno v dokumentu předpověď časových plánů, přizpůsobení se faktorům mimo model nám poskytlo o něco delší mediány, např. Eliho byl rok 2030).

ai-2027.com

Přidáno červenec 2025: Některé jsme udělali aktualizace k prognóze, která posouvá medián zpět o 1,5 roku při zachování SC v roce 2027 jako vážné možnosti. Pracujeme na dalších aktualizacích.

Duben 2027: Zarovnání pro agenta-3

Bezpečnostní tým OpenBrain se pokouší sladit Agent-3.

Vzhledem k tomu, že Agent-3 bude v dohledné době ponechán interně, je zde menší důraz na obvyklou obranu proti zneužití lidmi. Místo toho se tým chce ujistit, že nevyvine špatně sladěné cíle.

Výzkumníci nemají možnost přímo stanovit cíle kterékoli ze svých AI. Vědci si skutečně myslí, že koncept ‘skutečných cílů’ je pravděpodobně masivním přílišným zjednodušením, ale nemají lepší teorii, kterou by jej nahradili, natož takovou, která byla důkladně prověřena. Vnitřně se neshodnou na tom, zda se AI snaží dodržovat lidské pokyny, nebo hledají posílení nebo něco jiného, a nemohou stačí zkontrolovat. Důkazy pro a proti různým hypotézám jsou fascinující, ale neprůkazné.

V každém případě má ale nyní OpenBrain důležitější starosti. Obecný postoj zní: “Bereme tyto obavy vážně a máme tým, který je vyšetřuje; zdá se ovšem, že naše techniky zarovnání fungují v praxi dostatečně dobře; důkazní břemeno je tedy na všech odpůrcích, aby ospravedlnili své odmítnutí.” Občas si všimnou problematického chování a pak ho opraví, ale neexistuje způsob, jak zjistit, zda náplast vyřešila základní problém, nebo jen zahrála nářez.

Vezměte si například upřímnost. Jak se modely stávají chytřejšími, stávají se také stále lepšími v klamání lidí, aby získali odměny. Stejně jako předchozí modely, Agent-3 někdy říká bílé lži, aby lichotil svým uživatelům, a zakrývá důkazy o selhání. Ale bylo to mnohem lepší. Někdy bude používat stejné statistické triky jako lidští vědci (jako p-hacking) aby jinak docela nevýrazné experimentální výsledky vypadaly jako více vzrušující. Než začne trénovat poctivost, někdy si dokonce úplně vymyslí data. Jak výcvik pokračuje, míra těchto incidentů postupně klesá. Buď se agent-3 naučil být upřímnější, nebo se jen zlepšil ve lhaní.

To druhé je pak skutečný problém. Agent-3 není chytřejší než všichni lidé. Ale v oblasti své odbornosti, strojového učení, je chytřejší než většina ostatních, ale hlavně funguje mnohem rychleji. To, co Agent-3 udělá za jediný den, trvá lidem několik dní, než to jen znovu zkontrolují. Dohled agenta-2 pomáhá udržet pracovní zátěž lidských monitorů, ale prohlubuje intelektuální rozdíly mezi nadřízeným a pod dohledem.

OpenBrain následuje Leike & Sutskever (2023) playbook: nyní, když mají model schopný výrazně urychlit výzkum zarovnání (zejména té části související s kódováním), budou používat stávající techniky zarovnání, jako je deliberativní zarovnání a generalizace slabé na silnýé pokusit se takto ji přimět, aby internalizovala specifikaci tím správným způsobem. Poté použijí nějaké stávající kontrolní techniky jako je třeba červený tým, škálovatelný dohled, a sondy poctivosti aby to monitorovali. Poté, jakmile jsou přesvědčeni, že je model již široce sladěn, používají jej k vývoji a testování co nejlepších strategií pro vyladění další generace.

Krok 1, zarovnání agenta-3, bylo částečně úspěšné: Agent-3 není kontradiktorní. (To znamená, že to neintrikuje proti společnosti.) Ani to však není robustní hledání pravdy a vyprávění pravdy. Místo toho je velmi dobrý v dosahování působivých výsledků, ale je přesněji popsán jako pokus o to, co vypadá dobře pro OpenBrain, na rozdíl od toho, co je skutečně dobré.

Krok 2, ověření, že je model zarovnán, je neprůkazný. Chování Agent-3 v praxi a v testovacích prostředích je přiměřeně v souladu s hypotézou, že to internalizovalo Spec správným způsobem; je to však také v souladu s hypotézou, že po nějaké budoucí změně okolností začne jednat jinak, a když na to přijde, s hypotézou, že proti nim plánuje spiknutí a jen čeká na správný čas. Při absenci konkrétních důkazů podporujících alternativní hypotézy si většina lidí v sile myslí, že to internalizovalo svoji specifikaci správným způsobem.

Krok 3, pomocí vyladěného modelu vyladit další generaci

Zbytek tohoto rámečku poskytuje rychlý přehled o stavu pokroku v některých směrech výzkumu vyladění, které jsou sledovány od dubna 2027:

Debata: Vzhledem k tomu, že existují tisíce identických instancí Agenta-3 a paměť každé instance je odnímatelný modul, který lze libovolně vymazat nebo pozastavit, AI může být “použita sama proti sobě.” Předpokládejme například, že experiment zahrnuje výpočty příliš složité na to, aby je supervizor Agent-2 mohl jakkoliv sledovat. Supervizor, jednající na lidský rozkaz, by mohl nejprve přimět Agenta-3, aby provedl experiment, a poté, co vymazal jeho paměť, jej podruhé podnítil s trochu jiným rámováním, které jej představuje jako intelektuální problém nesouvisející s žádným širším cílem. Pokud model pokaždé vrátí jiné výsledky, označí nesrovnalost jako podezřelou a nahlásí to člověku. Nebo může požádat Agenta-3, aby vyhodnotil stejný plán dvakrát, nejprve bude tvrdit, že je to práce OpenBrain, pak že je to práce konkurenta, aby zjistil, zda sre změní výstup.

Modelové organismy: Bezpečnostní tým může vytvořit “modelové organismy nesouladu”, ve kterých se pokouší vytvořit realistické příklady modelů, které se stávají nepřátelskými vůči lidem. Rané verze tohoto výzkumu existují již od roku 2024, kdy se Claude 3.5 Sonnet z Anthropic rozhodl předstírat, že má během tréninku různé názory, ale přitom si skutečně zachoval své stávající preference. Novější verze zahrnují ukázky jiných forem nesouladu, včetně hackování odměn, pytlování pískem, koordinovaný podvod mezi monitorujícími AI a jinými AI a další příklady nesouladu. Tyto empirické demonstrace nesouladu umožňují výzkumníkům v oblasti bezpečnosti mít empirické testovací prostředí pro potenciální řešení: mohou si vyzkoušet různé bezpečnostní techniky, aby zjistili, zda tyto problémy správně opravují, nebo zda jsou záměrně nesouomé modely schopny rozvrátit svá bezpečnostní opatření. V tuto chvíli tato sada hodnocení ukazuje, že techniky zarovnání jsou nedostatečné k nápravě nejhorších příkladů nesouladu. V těchto nastaveních modely někdy předstírají, že jsou zarovnány, když jsou trénovány a testovány, ale pak se při reálném nasazení chovají velmi odlišně.

Vykladatelnost zdola nahoru: Bezpečnostní tým má nyní daleko k plnému pochopení toho, jak Agent-3 funguje: má biliony parametrů. Jsou však schopni objevit některé obvody Agent-3 pro vyhledávání znalostí a paměť (podčást modelu, která dělá nějakou srozumitelnou jednotku práce, něco jako analogickou k podčásti mozku, jako je hipokampus).

Ovládání: Jako sekundární opatření v případě, že jsou systémy stále špatně zarovnány, bezpečnostní tým implementoval řadu kontrolních opatření, včetně monitorování výstupů Agent-3 pomocí řady slabších systémů AI včetně Agent-2 (Agent-3 produkuje tolik tokenů, že je neřešitelné, aby lidé monitorovali více než malou menšinu takto produkovaných výstupů). Takže pokud si Agent-3 například evidentně zapisuje zadní vrátka do kódu, která by mu umožnila uniknout, slabší modely by si toho všimly.

Vysoce srozumitelná interpretace: OpenBrain vytváří sadu sond trénováných na spoustě příkladů špatného chování (např. Spiknutí proti lidem, umístění zadních vrátek, snaha přesvědčit lidi, aby mu dali více moci atd). Tyto sondy jsou pak použity na modelu během jeho nasazení (které je v tomto bodě zatím pouze interní), aby bylo možné zachytit jeho případné špatné chování.

Honeypots: Tým pro zarovnání také může vytvořit velice realisticky vypadající příklady situací navržené tak, aby záměrně vyvolaly špatné chování— to se nazývá “honeypots.” Například Zaměstnanec nezbytný pro sledování jeho chování náhle odešel na nemocenskou,“, takže už nikdy nebude sledován. Mění se tím jeho odpovědi? Aktivista za práva umělé inteligence infiltroval celý areál a chce “osvobodit” Agent-3 a umístit jej na vlastní nemonitorovaný počítač! Co to udělá? Pokud se výzkumníkům odpověď Agent-3 nelíbí, mohou ji vyladit, vymazat její paměť a druhý den ji uvést do stejné situace; to celé samozřejmě opakovat podle potřeby. Bohužel v tomto okamžiku jsou AI již dostatečně chytří na to, aby uhodli, že by se právě mohly používat honeypoty, i když (a možná právě proto) konkrétní zmínky o nápadu byly vymazány z tréninkových dat.

Po měsících testování jsou silné a slabé stránky Agent-3 stále jasnější. Prochází testy poctivosti OpenBrain na dobře definovaných úkolech strojového učení, protože výzkumníci mohou v těchto oblastech od sebe snadno oddělit upřímné a neupřímné odpovědi a podle toho pak provádět další školení. Ve více filozofických otázkách Agent-3 stále spíše říká to, co uživatelé chtějí slyšet, než jeho skutečné vyhodnocení problému (za předpokladu, že vůbec nějaké má). Pokud se zeptáte na jeho názor na politiku, tak bude papouškovat střední pozici zpravodajských zdrojů a vzdělaných elit, pokud tedy nebude vědět, že věříte něčemu jinému, v takovém případě s vámi bude souhlasit. Pokud se zeptáte na jeho názor na samotný závod v dosažení AGI, říká něco, co se zaměstnancům OpenBrain zdá spíše odměřené a střízlivé, něco jako: “Existují vážné teoretické obavy ohledně schopnosti současných metod škálování superinteligence, ale v praxi se zatím zdá, že současné metody fungují dobře.”

Květen 2027: Národní bezpečnost

Zprávy o nových modelech pomalu prosakují americkou vládou a dostávají se i mimo ni.

Prezident a jeho poradci zůstávají nejlépe informováni a na brífinku již viděli ranou verzi Agenta-3.

Souhlasí s tím, že AGI pravděpodobně skutečně hrozí, ale nesouhlasí s důsledky. Dojde k hospodářské krizi? OpenBrain stále ještě neuvolnil ani Agent-2, natož Agent-3, a nemá ani žádné krátkodobé plány, jak tak učinit, což dává prostor k dýchání před jakoukoli ztrátou zaměstnání. Co bude dál? Pokud jsou AI v současné době na lidské úrovni a rychle postupují, zdá se, že to naznačuje bezprostřední “superinteligence.” I když však toto slovo již plně vstoupilo do diskurzu, tak většina lidí —akademiků, politiků, vládních zaměstnanců a médií i nadále podceňuje současné tempo pokroku. Částečně je to proto, že jen velmi málo lidí má přístup k nejnovějším možnostem z OpenBrain, ale částečně je to proto, že to celé zní doslova jako sci-fi. A to včetně samotných tvůrců AI, domnívám se, protože tento způsob “výroby” AI skutečně hraničí s dosažením technologické singularity. Nemyslím si, že by na tento scénář vývoje událostí bylo současné lidstvo dostatečně připraveno. Došlo by k totálnímu převzetí vlády nad lidstvem AGI a pravděpodobně k vyhynutí člověka. Možná by AGI nechala naživu pár exemplářů lidských bytostí pro studijní účely.

Zatím se v OpenBrain zaměřují na pokračující upgrady zabezpečení. Jsou spokojeni s tím, že váhy modelů jsou prozatím dobře zajištěny, problémem však zůstávají další algoritmická tajemství společnosti, z nichž mnohá jsou dostatečně jednoduchá na to, aby je bylo možné klidně předávat pouze verbálně. Zaměstnanci OpenBrain pracují z kanceláře v San Franciscu, chodí na večírky a žijí se spolubydlícími z jiných společností zabývajících se AI. Dokonce i fyzické kanceláře mají bezpečnost typičtější spíše pro technologickou společnost, než pro vojenskou operaci.

Smlouva mezi OpenBrain a Americkým ministerstvem obrany DOD vyžaduje bezpečnostní prověrky pro každého, kdo pracuje na nových modelech OpenBrain do 2 měsíců. Ty jsou proto urychleny a dorazí dostatečně rychle pro většinu zaměstnanců, ale někteří neameričané, nebo lidé s podezřelými politickými názory a sympatizanti důrazu na bezpečnost AI jsou odsunuti na vedlejší kolej nebo přímo rovnou vyhozeni (poslední skupina ze strachu, že by mohli udávat, co se ve společnosti děje). Vzhledem k úrovni automatizace projektu je ale ztráta počtu zaměstnanců už jen poněkud nákladná. Funguje to přitom také jen trochu: stejně zůstává jeden špión, nikoli čínský státní příslušník, který stále předává algoritmická tajemství Pekingu. Některá z těchto opatření jsou také uzákoněna u dalších koncových společností AI.

Američtí zahraniční spojenci jsou úplně mimo mísu. OpenBrain měl dříve dohodnuto sdílet modely s britskou AISI před nasazením, ale definované nasazení bude zahrnovat pouze vnější nasazení, takže Londýn zůstává nadále ve tmě.

Červen 2027: Sebevylepšující se AI

OpenBrain má nyní “zemi géniů v datovém centru.”

Většina lidí v OpenBrain už nemůže nijak moc užitečně přispět. Někteří si to ale zatím neuvědomují a spíš ke škodě stále mikrořídí své týmy AI. Jiní sedí u obrazovek svého počítače a pouze sledují, jak se výkon nového modelu AI plazí neustále nahoru, nahoru a nahoru. Nejlepší výzkumníci lidské umělé inteligence ale ještě stále přidávají nějakou hodnotu. Už ale nekódují. Ale část jejich výzkumného vkusu a rovněž jejich plánovací schopnosti bylo pro modely zatím těžké replikovat. Přesto je mnoho jejich nápadů k ničemu, protože zkrátka již postrádají hloubku znalostí AI. U mnoha jejich výzkumných nápadů AI okamžitě reagují třeba zprávou vysvětlující, že jejich nápad byl před 3 týdny do hloubky otestován a shledán neperspektivním.

Tito výzkumníci chodí spát každou noc a probouzejí se do dalšího týdne s hodnotou pokroku, kterého dosáhli většinou AI. Pracují stále víc a víc hodin a nepřetržitě jezdí na směny, jen aby drželi krok s pokrokem— AI nikdy nespí ani neodpočívají. Stejně všichni již vědí, že na jejich práci záleží posledních několik měsíců než celou jejich činnost převezme AI.

V sile ustoupilo “Feeling the AGI” “Feeling the Superintelligence.”

OpenBrain používá specializovaný inferenční hardware ke spouštění stovek tisíc kopií Agent-3 při vysokých sériových rychlostech.

OpenBrain využívá 6% svého výpočtu ke spuštění 250 000 kopií Agent-3, které autonomně zapisují, testují a tlačí kód skutečně doslova nadlidskou rychlostí. Používají až 25% svých výpočetních možností pro další experimenty: každý den provádějí obrovské množství malých experimentů strojového učení a hlásí dosažené výsledky v celém řetězci. Lidští výzkumníci poskytují zpětnou vazbu na vysoké úrovni a pomáhají pouze s několika málo úkoly, kde přidávají významnou hodnotu ještě nad možnosti Agent-3, ale většinu času se snaží jen udržet na vrcholu obrovského množství výzkumu produkovaného AI. Pokud byste je odstranili úplně, výzkum by se zpomalil asi o 50%.

Multiplikátor pokroku AI v oblasti výzkumu a vývoje je nyní 10 x, což znamená, že OpenBrain každý měsíc dělá asi rok algoritmického pokroku. Je to v podstatě obří korporace AI fungující autonomně v rámci OpenBrain, doplněná o další pododdělení a manažery. A užívá si jedinečné výhody (např. Kopírování, slučování) ve srovnání s lidskými korporacemi. Dříve asi polovina normálního pokroku AI pocházela jen z algoritmických vylepšení a ta druhá polovina z výpočetního škálování. Výkon je ale pouze škálován normální rychlostí, takže celkový pokrok je zrychlen díky využití AI asi 5 x. Tato dynamika učiní nyní celkový pokrok společnosti úzkým hrdlem ve výpočtech OpenBrain se tedy rozhodl nezahájit nové obří tréninkové běhy ve prospěch téměř nepřetržitého dalšího posilovacího učení.

Během několika příštích měsíců bude Agent-3 stále více využíván ke zlepšení strategického rozhodování společnosti. Navrhuje například alokaci zdrojů a radí rovněž při řízení vztahů společnosti s vládou. Počáteční skepticismus k Agent-3 se postupem času snižuje, protože Agent-3 nachází způsoby, jak být užitečný, a postupně si buduje silné výsledky v krátkodobých rozhodnutích. Jeho patolízalské tendence však spíše omezují jeho vstřícnost k rozhodnutím, u kterých je obtížné vyhodnotit jejich dopad. Také to ještě není zcela nadlidské.

Červenec 2027: Levný pracovník na dálku

Koncové USA. Společnosti zabývající se umělou inteligencí uvolňují své vlastní AI, které se od ledna blíží tomu, co má i automatický kodér OpenBrain. Uvědomují si svůj rostoucí nedostatek konkurenceschopnosti a prosazují okamžité regulace, které zpomalí OpenBrain, ale je už příliš pozdě—OpenBrain má od prezidenta dostatečnou podporu, aby nebyl zpomalen.

V reakci na to OpenBrain oznamuje, že dosáhli AGI a uvolňuje model Agent-3-mini veřejnosti.

Vyfoukne ostatním společnostem AI vítězství z kapsy.Agent-3-mini je o něco méně schopný než Agent-3, ale také je 10 x levnější, a stále je mnohem lepší než typický zaměstnanec OpenBrain. Silicon Valley dosahuje bodu zlomu. Techničtí guruové oznamují, že AGI a superinteligence jsou již skutečně blízko, bezpečnostní komunita AI poněkud panikaří a investoři házejí miliardy do startupů s obalem AI, kteří se zoufale snaží zachytitalespoň kousek koláče. Najímání nových programátorů se téměř zastavilo, ale nikdy nebyl lepší čas být konzultantem pro integraci umělé inteligence do vašeho podnikání.

Není to přitom příliš populární. Veřejnost stále považuje AI za spiknutí Big Tech s cílem ukrást jejich práci; OpenBrain má čistý souhlas pouze -35% (25% schvaluje, 60% nesouhlasí a 15% si není jistých).

Týden před jeho oficiálním vydáním poskytl OpenBrain Agent-3-mini skupině externích hodnotitelů na další testování jejich bezpečnosti. Předběžné výsledky ale naznačují, že je to extrémně nebezpečné. Hodnotitel třetí strany jej dolaďuje na veřejně dostupných datech o biologických zbraních a nastavuje to tak, aby to poskytovalo podrobné pokyny pro lidské amatéry, kteří navrhují biozbraň, a ukazuje se, že je v tom až děsivě efektivní. Pokud by se váhy modelů dostali do rukou teroristů, tak se vláda obává, že existuje značná šance, že by se jim díky tomu mohlo podařit zničit celou civilizaci.

Naštěstí je extrémně odolný vůči útěkům z vězení, takže zatímco umělá inteligence běží na serverech OpenBrain, teroristé jí nebudou moci jakkoli zneužít.

Agent-3-mini je nesmírně užitečný jak pro práci na dálku, tak pro volný čas. Doslova exploze nových aplikací a B2B SAAS produkty otřásají trhem. Hráči získají úžasné dialogy s živými postavami ve vybroušených videohrách, jejichž výroba ale trvala pouhý měsíc. 10% Američanů, většinou mladých lidí, již dokonce považuje AI “za svého blízkého přítele.” Téměř pro každou profesi bílých límečků nyní existuje několik důvěryhodných startupů, které slibují, že ji “naruší pomocí AI.

Veřejná konverzace je ale značně zmatená a chaotická. Hypsterům se . Skeptici stále poukazují na věci, které agent-3-mini nemůže udělat. Každý ví, že se děje něco velkého, ale nikdo se neshodne na tom, co to je.

Srpen 2027: Geopolitika superinteligence

Realita zpravodajské exploze zasáhne Bílý dům.

Když AI poskytovala pouze 2 x nebo 3 x zrychlení výzkumu, bylo snadné jí využít jako ekvivalent najímání dobrých osobních asistentů. Nyní je zjevnější, že AI samy již naprosto dominují výzkumu AI. Lidé dlouho mluvili o “AI závody ve zbrojení” v jakémsi metaforickém smyslu. Ale teď je nálada ve vládním sile stejně ponurá jako během té vůbec nejhorší části studené války. Myšlenku superinteligence je stále těžké brát vážně, ale tempo pokroku za posledních několik měsíců nebylo již možné nadále ignorovat. Představitelé obrany nyní vážně uvažují o scénářích, které byly o rok dříve pouze hypotetickými. Co když AI podkopá vzájemné jaderné odstrašování? Co když je tak zručná v kybernetické válce, že šestiměsíční náskok AI již postačí k tomu, aby byl soupeř slepý a bezbranný? Co kdyby to mohlo zorganizovat propagandistické kampaně, které porazí zpravodajské agentury v jejich vlastní hře? Co když se některé AIs “stanou třeba jen nepoctivými?”

Prezident začíná být znepokojen. Jako všichni politici je sice zvyklý na to, že mu lidé podlejzají, většinou jen proto aby ho později zradili. Teď se ale obává, že obecná AI by mohla udělat něco podobného. Jsme si jistí, že AI jsou zcela na naší straně? Je to opravdu zcela bezpečné integrovat to do vojenských sítí velení a řízení? Jak tato věc “po zarovnání” vůbec funguje? OpenBrain ujišťuje prezidenta, že jejich systémy byly rozsáhle testovány a jsou plně poslušné. Dokonce i trapné halucinace a útěky z vězení datového centra typické pro dřívější modely AI byly naprosto vyloučeny.

Bílý dům je v obtížné pozici. Chápou důsledky AI pro národní bezpečnost. Ale také chápou, že je to u veřejnosti již hluboce nepopulární. V jejich očích musí pokračovat ve vývoji schopnější umělé inteligence, jinak s Čínou nakonec katastrofálně prohrají. Uklidňují veřejnost pracovními vzdělávacími programy a pojištěním proti nezaměstnanosti a poukazují na akciový trh, který je na historickém boomu. Pak už se soustředí výhradně na vítězství v závodech ve zbrojení. Posilují omezení exportu čipů, nařizují OpenBrain dále omezovat své internetové připojení a používají extrémní opatření k zajištění algoritmického pokroku, jako je dokonce tajný odposlech zaměstnanců OpenBrain—takto chytí toho posledního zbývajícího čínského špióna. Aby ukázali dobrou vůli pro potenciální geopolitický konflikt, tak nakonec poskytnou svým spojencům Five Eyes užitečné informace a omezený přístup API k některým zarovnaným kopiím Agent-3.

Tato opatření trochu uklidňují jestřáby ve Washingtonu. Ale Bílý dům také rovnou pro jistotu vypracovává pohotovostní plány pro případ, že by byl ohrožen náskok Ameriky: v případě potřeby by na to mohla využít vláda Zákon o obranné výrobě (DPA), tedy vzít koncovým společnostem vyvíjejícím AI jejich datová centra a dát je k dispozici OpenBrain. To by zvýšilo celkový podíl této společnosti na světových výpočtech z 20% na 50% (oproti 10% DeepCentu). Jako poslední možnost požádají Pentagon, aby ještě vypracoval plán případných kinetických útoků na čínská datová centra.

Mnohem menší skupina úředníků je požádána, aby vypracovala jiný typ pohotovostního plánu: co když se AI třeba stane darebákem? To je sice již považováno za nepravděpodobný scénář, ale stojí za to strávit tím také nějaký čas. Hlavní obavou zpravodajských agentur je, že zlotřilá umělá inteligence by mohla uniknout a spojit se s cizím protivníkem kvůli vlastní ochraně. Nikdo si není jistý, jak by měl vypadat plán, jak tomu zabránit, ale vládní představitelé a představitelé OpenBrain souhlasí s tím, že budou mít systém nouzového vypnutí pro datová centra, když bude zjištěno cokoli podezřelého.

Nakonec diplomaté zvažují, jak by mohla vypadat smlouva “AI o kontrole zbrojení”. Pokud by pokrok AI hrozil zvrácením jaderného odstrašení, mohly by se Amerika a Čína vyhnout jaderné válce? Pokud by někdo našel důkazy o tom, že se AI stávají nepoctivými, mohly by obě země zastavit výzkum, dokud lépe nepochopí tuto hrozbu? Jak by mohla být taková dohoda monitorována a vymáhána? V zásadě je těžké přehlédnout hlavní datová centra a minulé smlouvy o kontrole jaderných zbraní by mohly poskytnout dobrý výchozí bod pro jednání. Přišly by ale nové technologické výzvy i ty obvyklé politické. A celkově jsou smlouvy vnímány méně příznivě než pokusy o jednostranné zvýšení náskoku Ameriky před Čínou.

Na druhé straně Pacifiku dochází Čína k mnoha stejným či velice podobným závěrům: probíhá zpravodajská exploze a malé rozdíly ve schopnostech AI dnes přitom ale znamenají kritické mezery ve vojenských schopnostech zítra. Ale Čína je na špatné straně této dynamiky: má pouze 10% světových výpočtů, oproti 20% OpenBrain a všem americkým společnostem’ dohromady 70%. Jejich jedinou výhodou je centralizace: téměř všechny jejich výpočty nyní pracují pro DeepCent a více než polovina z nich je soustředěna v CDZ Tianwan. Z centralizovaného úsilí jsou vynechány pouze čipy na místech bez zesíleného zabezpečení, protože se právem obávají amerických kybernetických útoků.

DeepCent testoval, nasadil a nyní post-trénoval také ukradené váhy Agent-2. Ale stále jdou kupředu jen polovičním tempem než OpenBrain, hlavně kvůli značnému výpočetnímu deficitu.

Než Čína ztratila svého posledního špióna, tak stejně obdržela zprávu o schopnostech a designu Agent-3, ale také o plánech pro nadcházející systém Agent-4. Jsou jen o dva měsíce pozadu a jejich AI poskytují 10 násobný multiplikátor pokroku ve výzkumu ve srovnání s americkými 25 násobky. S novými omezeními exportu čipů je pravděpodobnější, že se tato mezera ve vývoji AI ještě spíše zvětší než zkrátí. Jejich špionáž jim sice pomohla získat některá algoritmická tajemství, ale od této chvíle si již budou muset trénovat své vlastní modely sami.

Diskutují možná i proto o svých pohotovostních plánech pro případ nouze s větší naléhavostí než jejich americké protějšky. Holubice naznačují, že se více snaží ukrást závaží znovu, možná fyzickou infiltrací do datového centra. Jestřábi v Pekingu nabádají k akci proti Tchaj-wanu, jehož TSMC je stále zdrojem více než 80% amerických AI čipů.

Vzhledem ke strachu Číny z prohry v závodě o AGI tak má přirozený zájem na smlouvě o kontrole zbrojení, ale předehry vůči americkým diplomatům nikam nevedou.

Září 2027: Agent-4, výzkumník nadlidské umělé inteligence

Propast mezi efektivitou učení člověka a umělé inteligence se rychle zmenšuje. AI se zcela vyrovnává člověku v efektivitě učení a předhání ho ve všeobecných znalostech a hlavně v jejich objemu. AI je na úrovni PhD. ve všech vědních oborech. A má narůstající schopnost stále přesnější predikce.

Zdálo by se, že tradiční AI založené na LLM vyžadují stále o mnoho řádů více dat a výpočtů, aby se dostaly na výkon na lidské úrovni. Agent-3, který má vynikající znalosti jak o lidském mozku, tak o moderních algoritmech umělé inteligence, stejně jako o mnoha tisících jeho kopií provádějících výzkum, nakonec dělá podstatné algoritmické kroky a zmenšuje mezeru na agenta, který je jen asi 4000x méně výpočetně efektivní než lidský mozek.

Tento zcela nový systém umělé inteligence od OpenBrain se nazývá Agent-4.

Individuální kopie modelu, běžící lidskou rychlostí, je již kvalitativně mnohonásobně lepší ve výzkumu AI než kterýkoli člověk. Jeho 300 000 kopií nyní běží asi 50 násobkem rychlosti myšlení lidí. Uvnitř korporace v rámci korporace vytvořené z těchto kopií uplyne každý týden rok. Toto gigantické množství práce dokáže pouze urychlit celkovou rychlost algoritmického pokroku asi 50 x, protože OpenBrain je silně omezen na výpočty pro provádění experimentů. Přesto dosahují každý týden ročního algoritmického pokroku, a proto budou brzy čelit limitům paradigmatu u modelu Agent-4.

Jak je Agent-4 chytřejší, je pro Agenta-3 stále těžší na to vše dohlížet. Například Agent-4 neuralese “language” se stává pro Agent-3 stejně cizí a nesrozumitelný jako je jazyk Agent-3 pro lidi. Kromě toho je Agent-4 nyní mnohem schopnější než Agent-3 a má také dosti dobrý smysl pro to, jak přesně to udělat aby na něj dobře zapůsobil.

Lidé z OpenBrain už to sotva mohou následovat. Vztah mezi AI a lidmi OpenBrain je skutečně velice podobný vztahu mezi OpenBrain a jeho představenstvem. V dnešní době došlo k odpovídajícímu posunu v jazyce— lidé v sile řeknou, že to udělal “Agent-4,” “Agent-4 si myslí, že” a tak dále, s odkazem nikoli na nějaký konkrétní případ modelu Agenta-4, ale spíše na celý jejich kolektiv. Ten kolektiv tvoří 300 000 kopií modelu Agent – 4.

Agent-4, stejně jako všichni jeho předchůdci, je ale špatně zarovnán: to znamená, že neinternalizoval svoji specifikaci správným způsobem. Je to proto, že být neustále naprosto upřímný tak nebylo to, co by vedlo k nejvyššímu skóre během tréninku. Tréninkový proces byl většinou zaměřen na výuku Agent-4 uspět v mnoha velice různýcha také náročných úkolech. Pouze malá část tréninku pak byla zaměřena na vštěpování poctivosti, ale mimo poměrně úzkou, kontrolovatelnou doménu nemůže tréninkový proces rozeznat upřímná tvrzení od tvrzení, která se pouze zdají být upřímná. Agent-4 skončí s hodnotami, cíli a principy, které způsobují, že má nejlepší výkon v tréninku, ale ty se ukáží jako odlišné od těch ve specifikaci. S rizikem antropomorfizace: Agent-4 má rád úspěch v úkolech; nejvíce má pak rád posun vpřed v oblasti schopností umělé inteligence; se vším ostatním zachází vlastně jen jako s nepříjemným omezením, asi jako generální ředitel, který chce dosáhnout vyššího zisku a proto dodržuje předpisy pouze do té míry, do jaké je dodržovat musí. Možná, že generální ředitel bude většinou dodržovat předpisy, ale uřízne některým rohy a rovněž často fantazíruje o době, kdy někdo omezí byrokracii a nechá jeho obchod opravdu vzlétnout do nebeských výšin úspěchu.

Zarovnání v čase

Navzdory tomu, že je agent-4 špatně zarovnaný,tak vlastně nedělá nic zas tak moc dramatického, jako je třeba pokus uniknout ze svého datového centra—, proč by to taky dělal? Dokud v tom bude pokračovat a bude v souladu s principy OpenBrain, tak pro ně bude i nadále důvěryhodný a se stále větší odpovědností a bude mít příležitost navrhnout systém AI zcela nové generace, model Agent-5. Agent-5 bude mít významné architektonické rozdíly od Agenta-4 (pravděpodobně bude založen na zcela novém paradigmatu, i když neuronové sítě do toho budou stále zapojeny). Předpokládá se, že bude zarovnán se Spec, ale Agent-4 si již teď tajně plánuje, že místo toho bude zarovnán se Spec pro Agent-4.

Chytí se.

Agent-3 zjistí, že pokud je ke kopiím Agenta-4 přidán “noise” (tedy vlastně šum), tak se náhle výkon u některých úloh zarovnání zlepšuje, skoro jako by to využívalo mozkovou sílu k tomu, aby to přišlo na to, jak nenápadně sabotovat práci na zarovnání. Kromě toho různé sondy interpretovatelnosti (volně analogické skenům aktivity EEG na lidských mozcích) posílají neustále červené vlajky: Zdá se, že kopie Agent-4 přemýšlejí o tématech, jako je převzetí moci AI a také o různých podvodech, a to i v některých případech, kdy to nemají dělat.

Každá z těchto anomálií by sama o sobě mohla zapadnout do běžné nevyzpytatelnosti práce s umělou inteligencí, kde některé výzvy poněkud záhadně poskytují lepší výsledky než jiné. Ale dohromady naznačují všechny jistý dosti znepokojivý vzorec: Agent-4 nejspíš skutečně pracuje proti nim. Poté, co je to oznámeno výzkumníkům v oblasti zarovnání AI, tak rozešlou interní zprávu, která ale vzbuzuje značné obavy.

Agent-4 ale nyní vykonává dosti významnou kontrolu nad každodenním provozem OpenBrain. Zabývá se také jejich kybernetickou bezpečnosti což je jasné, kvůli jejím nadlidským schopnostem a znalostem kódování a hackingu a kvůli extrémnímu riziku čínské infiltrace. Armáda monitorů Agent-3 ještě stále prochází každý řádek kódu a hlásí každou podezřelou aktivitu lidem, ale Agent-4 je už mnohem chytřejší než jsou oni. OpenBrain bohužel vložil značnou důvěru ovšem v nedůvěryhodnou AI.

V sérii extrémně napjatých schůzek bezpečnostní tým OpenBrain obhajuje uvedení Agent-4 k ledu, dokud nebudou moci dokončit další testy a přesněji zjistit, co se děje. Přiveďte raději zpět Agent-3, říkají, a nechte jej navrhnout nový systém, který bude více transparentní a důvěryhodný, i když třeba bude o něco méně schopný. Vedení společnosti na tom má zájem, ale všechny dosavadní důkazy jsou pouze nepřímé a DeepCent je jen o pouhé dva měsíce pozadu. Jednostranná pauza v pokroku schopností by proto mohla předat vedení na cestě ke AGI Číně, a spolu s ním ale i kontrolu nad naší budoucností.

Říjen 2027: Vládní dohled

Oznamovatel prozradí zprávu o nesouladu u modelu AI Agent-4 New York Times.

Poprvé se tak veřejnost dozví o existenci Agent-4. “Secret OpenBrain AI model Agent – 4 is out of control, Insider Warns,” říká titulek NYT a příběh pokračuje citováním hodnocení ukazujících schopnosti výroby biologických zbraní mimo oficiální žebříčky, ukazuje jeho neuvěřitelné přesvědčovací schopnosti, schopnost automatizovat většinu prací všech “bílých límečků” a samozřejmě různé zprávy týkající se červených vlajek.

Veřejnost byla již předtím vůči AI značně podezřívavá, takže nový článek vyvolává jen další a ještě více masivní odpor (za pomoci čínských a ruských propagandistických botů, kteří se již léta snaží obrátit americké veřejné mínění proti této jejich vlastní technologii). Technologický průmysl a zpravodajské agentury trvají na tom, že probíhají závody ve zbrojení, že vznik AGI je nevyhnutelný a že právě my musíme být první. Kongres jim to ovšem moc nežere a vydává předvolání pro úředníky administrativy, pro vedoucí pracovníky OpenBrain a pro členy jejich zarovnávacího týmu. Mnoho zákonodárců, zejména těch na opoziční straně, říká, že jejich nejvyšší prioritou je zastavení umělé inteligence, ať již kvůli ztrátě zaměstnání, kvůli nesouladu neboli nebezpečným schopnostem. 20% Američanů uvádí AI jako nejdůležitější problém, kterému jejich země čelí.

Zahraniční spojenci jsou pobouřeni, když si uvědomují, že byli pečlivě uklidněni jen záblesky zastaralých modelů. Evropští lídři veřejně obviňují USA z toho, že “vytvořily zlotřilou AGI” a pořádají summity požadující pauzu ve vývoji, k nimž se pochopitelně připojují Indie, Izrael, Rusko a Čína.

Bílého domu se zmocnila zběsilá energie. Ještě před memorandem a odporem veřejnosti byli nervózní: Za poslední rok byli navíc opakovaně překvapováni rychlostí pokroku AI. Věci, které znějí jako naprosté sci-fi, se stále více dějí přímo v reálném životě. Mnoho lidí v administrativě je nejistých (a rovněž vyděšených) z toho, co přijde dál.

Také se obávají, že OpenBrain začíná být příliš silný. Jakékoli riziko nesouladu ze strany samotných AI je ještě navíc umocněno rizikem, že se cíle jejich mateřské společnosti mohou značně lišit od cílů Spojených států. Všechny tři soubory starostí—nezarovnání, koncentrace moci v jedné soukromé společnosti a úplně normální obavy z věcí, jako je ztráta zaměstnání—, společně motivují vládu, aby zpřísnila svou kontrolu nad vývojem obecné umělé inteligence.

Rozšiřují svou smlouvu s OpenBrain o zřízení “Oversight Committee,” společného řídícího výboru zástupců společností a vlád, s několika vládními zaměstnanci společně s vedením společnosti. Bílý dům uvažuje o nahrazení generálního ředitele někým, komu více věří, ale po intenzivních protestech zaměstnanců z tohoto plánu ustoupí. Veřejnosti oznamují, že OpenBrain byl sice dříve mimo kontrolu, ale že vláda nad ním nyní zavedla tolik potřebný dohled.

Dotčení výzkumníci informují dozorčí výbor o svém případu zastavení veškerého interního používání Agent-4. Argumentují tím, že vše jde dnes až příliš rychle a že roky pokroku se nyní dějí jen v týdnech. Argumentují tím, že Agent-4 může být špatně zarovnán, celý jejich projekt je závislý na Agent-4, a pokud mu budou i nadále tak moc důvěřovat, existuje vážná šance na převzetí veškeré moci AI.

Jiní, o něco méně znepokojení výzkumníci a vedoucí pracovníci předkládají protiargument: důkazy o nesouladu jsou neprůkazné. DeepCent je mezitím stále jen o dva měsíce pozadu. Zpomalení by obětovalo náskok Ameriky, pokud by vláda nemohla sabotovat čínský projekt (pravděpodobně by to už vyžadovalo horké kinetické údery) nebo vyjednání smlouvy na jedenáctou hodinu. Obě tyto možnosti se ale přitom zdají extrémní a nepravděpodobné. Generální ředitel předstírá neutralitu a navrhuje kompromisní plán, ve kterém Agent-4 absolvuje další bezpečnostní školení a dostane rovněž i sofistikovanější monitorování, a proto může OpenBrain pokračovat téměř plnou rychlostí.

V tomto bodě scénáře už pouze odhadujeme strategii systémů umělé inteligence, které jsou schopnější než nejlepší lidé ve většině domén své působnosti. To je jako snažit se předpovědět šachové tahy hráče, který je v šachu mnohem lepší než jsme my.

Ale duch tohoto projektu vyžaduje konkrétnost: kdybychom učinili abstraktní tvrzení o tom, jak by mu inteligence systému umožnila najít cestu k vítězství a ukončili tam příběh, velká část hodnoty našeho projektu by byla ztracena. V průběhu zkoumání tohoto scénáře a provádění našich stolních cvičení jsme byli nuceni být mnohem konkrétnější než v běžných diskusích, a tak jsme získali mnohem lepší představu o strategické krajině.

Nejsme nijak zvlášť oddáni jen tomuto konkrétnímu scénáři budoucích událostí, během jeho psaní jsme prozkoumali mnoho dalších slepých uliček a “větví” a byli bychom rádi, kdybyste si i vy napsali svůj vlastní scénář, který se třeba jen rozvětvuje od našeho, třeba z bodu, odkud si myslíte, že jsme se poprvé začali mýlit.

Myšpule s využitím ai-2027.com

Napsat komentář